이 콘텐츠는 사이트 회원 전용입니다. 기존의 사용자라면 로그인 하세요. 새 사용자는 아래에서 회원가입 할 수 있습니다.

MIT, 영상서 음악편집 AI시스템 개발

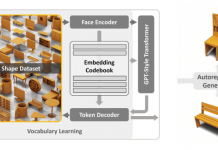

유튜브에서 내가 좋아하는 음악의 공연 영상을 보고 원하는 악기의 연주방법을 알 수 있다면 어떨까? 악기뿐만 아니라 사물의 소리를 계이름으로 표현하는 '절대음감'을 부러워하는 사람들에게 희소식이다. 인공지능(AI)이 연주하는 악기가 무엇이며, 어떤 소리가 나는지 찾아낸다. 매사추세츠 공과대학교(MIT, Massachusetts Institute of Technology)의 컴퓨터과학 인공지능연구소(CSAIL, Computer Science and Artificial Intelligence Laboratory, 이하 CSAIL)가 개발한 새로운 AI

![[보고서] 딥씨크 출현과 한국 AI 미래전략](http://itnews.or.kr/wp-content/uploads/2025/02/7-218x150.png)

![[2024 애플 동향] ③ 애플카 ‘프로젝트 타이탄’의 실패 원인](http://itnews.or.kr/wp-content/uploads/2024/03/1-2-218x150.png)

![[2024 애플 동향] ② 애플카 ‘프로젝트 타이탄’ 10년간 의 여정](http://itnews.or.kr/wp-content/uploads/2024/03/4-218x150.png)

![[2024 애플 동향] ① 애플 프로젝트 타이탄’ 종료](http://itnews.or.kr/wp-content/uploads/2024/03/Midjourney-218x150.png)